Identification de facteurs de risque de maladies, aide au diagnostic de cancers, au choix et au suivi de l’efficacité des traitements, surveillance des agents pathogènes… Dans de très nombreux domaines, la recherche biomédicale bénéficie aujourd’hui grâce aux progrès technologiques d’une avalanche d’informations – on parle de « données massives » ou Big data – relatives aux maladies étudiées, source fantastique de nouvelles connaissances et de progrès médicaux. Des flux d’informations auxquels l’esprit humain ne peut plus faire face seul et ne peut gérer qu’à l’aide d’outils informatiques de plus en plus élaborés. De quoi s'agit-il ?

La génomique, reine du Big data

Prenons l'exemple de la génomique, considérée comme la « reine du Big data ». L’obtention de la première séquence du génome humain (nos 23 000 gènes, soit un « texte » de 3 milliards de lettres), révélée en 2003, a pris près de 15 ans et coûté près de 3 milliards de dollars. Aujourd'hui, on peut obtenir la séquence du génome d’un individu en une journée, grâce aux techniques de séquençage « à haut débit », pour moins de 1000 dollars. Ce coût réduit – qui continue de chuter… - permet désormais de séquencer le génome de patients volontaires dans nombre d’études, qu’elles concernent l’autisme, les cancers, les maladies neurodégénératives ou autres. Un généticien se basait il y a peu sur l’analyse de quelques gènes chez un nombre limité de patients. Il peut aujourd’hui accéder à l’information de l’ensemble du génome de centaines voire de milliers de personnes, associée bien sûr à d'autres données sur ces patients (âge, sexe, maladies dont ils souffrent, médicaments qu’ils prennent, etc.). Le défi majeur pour les chercheurs aujourd'hui est l'interrogation et l’analyse de ces données, « rangées » dans des « entrepôts numériques », des bases de données consultables via Internet.

Donner du sens aux données

Partons d’un cas concret : on souhaite comparer des dizaines de génomes de patients répondant à un traitement avec ceux de patients chez lesquels ce traitement est inefficace, pour voir si des différences génétiques existent entre les deux groupes afin d’identifier des marqueurs prédisant l'efficacité de la thérapie en question. Une telle étude n'est pas « humainement » réalisable : c’est l'outil informatique, qui va, une fois programmé, effectuer cette vaste comparaison, passer en revue les 3 milliards de lettres de chaque génome, repérer des différences de texte entre les différents génomes, et identifier celles en relation avec la réponse au traitement. Une grande partie du travail des biologistes à l’initiative de l’étude va être d’interagir avec des bio-informaticiens, statisticiens et autres mathématiciens pour concevoir et développer des programmes et des algorithmes informatiques et statistiques dédiés à leur étude. Car comme le soulignent tous les chercheurs « les données seules ne sont rien, il faut leur donner du sens ».

La production exponentielle de séquences génomiques ne se limite pas au génome humain. On séquence à tout va l’ensemble de l’ADN contenu dans des échantillons de selles de patients – on parle de métagénomique – pour étudier le microbiote intestinal - ces 100 000 espèces microbiennes de notre flore intestinale dont la composition varie d'un individu à l'autre, ayant une influence majeure sur notre santé -, ou encore les génomes des virus, bactéries et autres microbes qui nous menacent, pour mieux les traquer (voir encadré PIBnet ci-dessous).

Mieux traquer les agents pathogènes

L’Institut Pasteur héberge 14 centres nationaux de référence, en lien avec Santé Publique France, chargés de la surveillance de maladies infectieuses en France et de l’alerte en cas d’épidémie : grippe, infections alimentaires (salmonelloses, listérioses…), rage, méningites bactériennes... « Depuis deux ans, au sein du programme PIBnet *, les génomes des souches de bactéries, virus ou champignons isolées chez des patients en France et envoyés pour analyse à plusieurs de ces centres – soit actuellement environ 25 000 souches par an - sont systématiquement séquencés sur une plateforme mutualisée, et toutes les données sur chaque souche (provenance, virulence, présence ou non de gènes de résistance, etc.) sont conservées », explique Sylvain Brisse, responsable de l’unité Biodiversité et épidémiologie des bactéries pathogènes à l’Institut Pasteur et titulaire d’une Chaire d’excellence pour l’épidémiologie génomique en Santé globale. « Cette base de données permet de croiser nos informations avec celles obtenues dans d’autres pays du monde pour détecter la diffusion d’agents pathogènes à l’échelle internationale. »

* Pasteur International Bioresources network.

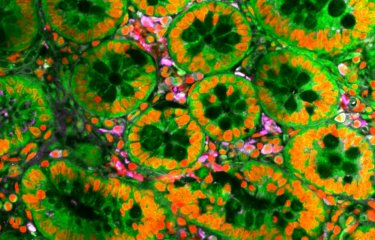

Un tsunami d’images

La deuxième « reine » du Big data, c’est l’imagerie, qu'il s'agisse d'imagerie médicale ou de microscopie. Les microscopes de plus en plus puissants et automatisés génèrent un tsunami d’images : Titan Krios™, le microscope le plus puissant du monde, peut fournir en une heure une quantité d’images équivalant en volume à 500 films vidéos en haute définition (voir plus bas), impossible à analyser par des cerveaux humains en un temps raisonnable. Là encore, le développement d’outils informatiques ad hoc est nécessaire. En matière d'analyses d'images, les chercheurs utilisent de plus en plus l'intelligence artificielle, et notamment le Deep learning ou apprentissage profond, né de l'essor du Big data et de l'augmentation de la puissance de calcul des ordinateurs (voir entretien ci-dessous). L'an dernier, grâce à 100 000 images de grains de beauté déjà caractérisés comme bénins ou malins, une équipe américaine a ainsi pu entraîner un ordinateur à effectuer le diagnostic de mélanomes. Une étude a récemment comparé les performances de la machine à celles de 58 médecins spécialistes, de 17 pays. Résultat : « La plupart des dermatologues ont fait moins bien », écrivent les chercheurs, 87% de bon diagnostic en moyenne contre 95% pour l'ordinateur. Bien « entraîné », l’ordinateur est donc plus performant… et n’a ni coup de fatigue, ni chute de concentration ! Ces techniques sont en passe de révolutionner le diagnostic des maladies et l'interprétation d'images médicales (radios, scanners, IRM, observation microscopiques des tissus de biopsies...) sera de plus en plus confiée à des ordinateurs, plus rapides et plus fiables, laissant plus de temps au médecin pour d’autres activités de recherche et pour sa relation au patient.

Le Big data est au cœur du renouveau actuel de d'intelligence artificielle.

Vous dirigez une équipe spécialisée dans l'imagerie*. En quoi le Big data a-t-il modifié la donne ?

Associé à l'augmentation des capacités de calcul des ordinateurs, le Big data a remis au goût du jour des techniques assez anciennes d'intelligence artificielle, qui donnent aujourd'hui des résultats précisément parce qu'on dispose de données massives. Il s'agit en particulier du « deep learning » ou apprentissage profond, dont on ne parlait pas il y a encore 10 ans. Grâce à ces techniques, on peut désormais par exemple entraîner un algorithme à distinguer des images de chiens et de chats - en lui donnant des milliers d'images d'apprentissage (annotées avec des 0 pour les chiens et des 1 pour les chats). Après un très grand nombre de calculs sur ces données d'entraînement, l'algorithme devient capable de généraliser et de reconnaître un chat ou un chien à partir d'une image inconnue. Et plus on entre de données, moins il se trompe. La reconnaissance vocale de votre portable, la traduction automatique des textes sur internet, la voiture automatique, les robots capables de manipuler des objets font tous appel au deep learning, qui arrive également dans le domaine médical. S'il commence à être utilisé en génomique, l'imagerie médicale est sans doute aujourd'hui le domaine dans lequel ses percées sont les plus évidentes.

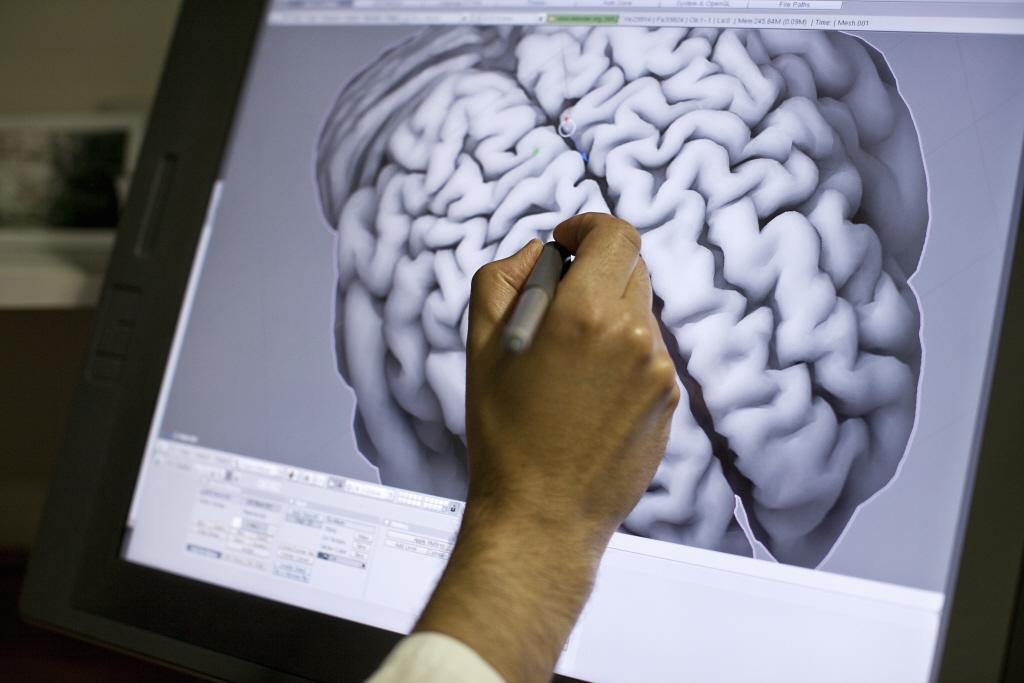

Quelles perspectives d'applications médicales permet l'intelligence artificielle ?

Nous travaillons par exemple avec l’unité de Neuropathologie expérimentale, dirigée par Fabrice Chrétien, sur le diagnostic de tumeurs cancers du cerveau de l'enfant à partir de biopsies après opération chirurgicale, provenant des hôpitaux Sainte-Anne et Necker à Paris. Actuellement, pour une même biopsie, deux pathologistes peuvent diverger sur le diagnostic dans un pourcentage notable de cas. Or diagnostiquer avec la plus grande précision le type de tumeur est déterminant pour la suite du traitement : chimiothérapie, radiothérapie, chirurgie supplémentaire, etc. Pour analyser la biopsie, l'expert dispose d’une image contenant typiquement 5 milliards de pixels – pour comparaison, une photo classique est composée d’environ 1 million de pixels seulement – et n’a pas le temps de l’inspecter entièrement au niveau maximal de résolution. Comme dans l'exemple des chats et des chiens, nous apprenons à un algorithme à déterminer le degré de sévérité d’une tumeur en l'entraînant à partir de centaines d'images de biopsies bien caractérisées par un groupe d’experts. Notre objectif à terme est de faciliter et compléter l'analyse histopathologique par l’expert humain, pour rendre le diagnostic plus fiable mais aussi plus rapide, car il peut s'écouler plusieurs jours avant qu'un spécialiste ne dispose de l'intégralité des tests pour expertiser une biopsie. En attendant d’atteindre cet objectif, les outils que nous développons pourraient déjà servir à attirer l’attention de l’expert sur des zones de l’image particulièrement informatives.

Ces méthodes peuvent-elles aussi accélérer la recherche ?

Absolument. A l’Institut Pasteur, l'équipe d'Arnaud Echard (unité de Trafic membranaire et division cellulaire) étudie la toute dernière étape de la division cellulaire, l’abscission, qui aboutit à la séparation des cellules, et dont les dysfonctionnements sont associés à la formation de nombreux cancers. L’équipe d’Arnaud a identifié 400 gènes potentiellement impliqués dans ce processus. Pour déterminer le rôle exact de ces candidats, il faut inactiver chaque gène un par un, filmer les divisions cellulaires et déterminer le moment de la scission, qui varie d'une cellule à l'autre. Les chercheurs font cela en inspectant les films à l’oeil, mais pour déterminer l’effet d’un seul gène, il faut observer environ 300 divisions cellulaires, soit 15 heures de travail, à faire 3 fois pour s'assurer de la reproductibilité, donc au total 45 heures par gène. Multiplié par 400, on arrive à 18 000 heures, soit plusieurs années de travail à temps plein ! Nous mettons donc en place un algorithme de deep learning en vue d'analyser chaque film presque instantanément. Si nous réussissons, cette équipe pourra rapidement connaître quels gènes influencent l’abscission, ce qui pourrait ouvrir la voie à des traitements contre les cancers.

*Christophe Zimmer a une formation d’astrophysicien. Son équipe comprend des mathématiciens, des physiciens, des informaticiens, des biologistes et une chimiste.

Des données titanesques !

En juillet dernier était inauguré à l'Institut Pasteur le « bâtiment Nocard » abritant le microscope le plus puissant du monde, Titan Krios™ – le seul de ce type en France dédié à l'étude des maladies, acquis avec l'aide de nombreux donateurs. Permettant l'observation à l'échelle atomique, ce cryo-microscope est automatisé, capable d'observer plusieurs échantillons à la fois et par là-même un gigantesque producteur de Big data. « Le stockage des données brutes générées par Titan est un premier défi majeur… elles pourraient remplir en peu de temps tous les disques durs du campus ! », souligne Michael Nilges, directeur du Département de Biologie structurale et chimie. « De plus, Il faut les analyser et les traiter pour déduire des images en trois dimensions. Quelques jours d’observations par Titan peuvent nécessiter des mois d’analyse informatique. Il nous faut augmenter la capacité de calcul de l’Institut.». En plus d’une équipe experte en microscopie à très haute résolution chargée de l’utilisation du microscope*, un groupe de scientifiques spécialement dédié au traitement des données a été recruté.

*unité d’Etudes structurales de machines moléculaires in cellulo, dirigée par Dorit Hanein.

Le Big data a poussé les chercheurs à partager leurs données

Données génomiques, imagerie... le nombre et la qualité des données collectées chez un même patient ne cesse de croître, avec des centaines d’informations recueillies chez un même individu, contre une dizaine il y a quelques années. Au Royaume-Uni, le projet « UK biobank » collecte une multitude de données de santé sur pas moins de 500 000 volontaires britanniques, dans le but « d'aider à améliorer la prévention, le diagnostic, et le traitement de nombreuses maladies sévères » - cancers, maladies cardiovasculaires, diabète, arthrite, ostéoporose, dépression ou démences…. Cette base est publique, gratuitement accessible aux chercheurs via Internet, sur inscription. La seule contrepartie demandée aux utilisateurs est d'informer UK Biobank des découvertes utilisant ces données « afin que les autres scientifiques puissent en bénéficier ». Ceci illustre un phénomène concomitant à l'avènement du Big data : le partage des données, le « data sharing ». Les chercheurs du monde entier mettent désormais leurs ressources en commun, collaborent pour regrouper leurs données et les analyser et donnent accès aux bases de données qu'ils organisent (voir encadré ci-dessous). Une condition sine qua non pour exploiter aux mieux les kyrielles d’informations existantes.

La base de données la plus complète au monde hébergée à l’Institut Pasteur

L’Institut Pasteur va héberger la plus grande base de données au monde sur l’autisme, non pas en nombre de patients – 800 actuellement et jusqu’à 3000 à terme - mais en quantité et richesse d’informations recueillies pour chacun : imagerie cérébrale, électro-encéphalogrammes, données génomiques, profils psychologiques, quotient intellectuel, qualité de vie, tests comportementaux, etc. « Comparée aux bases de données existantes pour l’autisme, c’est de la « haute-couture » », souligne Thomas Bourgeron, responsable de l’unité de Génétique humaine et fonctions cognitives à l’Institut Pasteur, pionnier dans la découverte et l’étude des gènes associés à l’autisme. Ce chercheur coordonne le volet génétique du programme européen EU-AIMS* impliquant 106 sites dans 37 pays d’Europe pour la recherche de nouveaux traitements contre l’autisme, grâce auquel ces multiples données ont été réunies. Dans son équipe, Guillaume Dumas précise : « L’élaboration de cette base de données est un défi technique, qui obéit aussi aux règles éthiques très strictes qui encadrent l’accès et la sécurisation des données de santé des personnes. Nous travaillons avec la Direction déléguée aux systèmes d’information (DSI) pour stocker et organiser le « rangement » de ces données, et avec des biostatisticiens du Centre de bioinformatique pour développer des outils pour leur analyse et faciliter l’accès des informations aux chercheurs.» Ce spécialiste des ondes cérébrales rappelle qu’il y a peu, il travaillait « avec de gros classeurs à l’hôpital contenant des centaines de DVD gravés d’électro-encéphalogrammes des patients » ! La centralisation de toutes les données numérisées dans la nouvelle base EU-AIMS, disponible via Internet aux scientifiques du monde entier, va permettre aux chercheurs, depuis leurs ordinateurs, de croiser une multitude d’informations pour lancer des analyses robustes et reproductibles qui vont sans aucun doute accélérer à vitesse grand V la compréhension de l’autisme. Et, c’est l’objectif, aboutir à des traitements adaptés aux différents types d’autisme et aux caractéristiques de chaque patient. L’enjeu est de taille : rappelons que les « troubles du spectre autistique » touchent plus de 1% de la population.

*European Autism Interventions - A Multicentre Study for Developing New Medications (EU-AIMS)

Profession : Data manager

Après un master en bio-informatique, une thèse de doctorat en génomique des populations sur un petit poisson cavernicole du Mexique, puis un stage post-doctoral sur un poisson - cubain celui-là -, Julien Fumey change de voie. Particulièrement intéressé par l’autisme, il décroche grâce à ses compétences en informatique et en analyse des génomes un poste de « Data/project manager », ouvert en janvier dernier à l’Institut Pasteur dans le laboratoire de Thomas Bourgeron : un nouveau métier né de l’essor du Big data. « Je dois coordonner la gestion des données du laboratoire et du projet EU-AIMS (voir encadré ci-dessus), qu’il s’agisse de leur stockage ou des démarches juridiques et légales », explique Julien, nouveau lien entre les chercheurs du laboratoire, les cliniciens des hôpitaux en charge des données des patients, les informaticiens et autres biostatisticiens du campus, et surtout le service juridique et la cellule éthique. « Avec les poissons, c’était simple, il suffisait d’une autorisation pour les collecter et les transporter », remarque Julien. « Avec l’humain, j’ai découvert une réglementation extrêmement stricte, avec de multiples demandes d’autorisation auprès de comités d’éthique, de la CNIL, etc. Tout ce qui touche à la protection et à la sécurisation des données relatives aux patients prend énormément de temps, d’autant que l’Institut Pasteur a un haut niveau d’exigence dans ce domaine. » Une des missions du Data manager…

Avec l’humain, j’ai découvert une réglementation extrêmement stricte, avec de multiples demandes d’autorisation auprès de comités d’éthique, de la CNIL, etc.

Julien Fumey Data manager au sein de l'unité Génétique Humaine et Fonctions Cognitives, à l'Institut Pasteur.

Interprétation graphique d'une cartographie de gènes. Crédit : Adobe Stock

Un défi de taille : le stockage des données

Un autre défi considérable du Big data –technique et économique- est de stocker les données, les organismes de recherche devant acquérir toujours plus de serveurs de stockage et de supercalculateurs. Celles d’un seul génome humain peuvent occuper un espace équivalent à 100 000 photos de vacances : dans le cadre d’une vaste banque de données européenne sur l'autisme (voir encadré plus haut), 800 000 euros ont par exemple été consacrés au seul stockage des données génomiques des patients…

Mais des avancées inestimables sont attendues du Big data en recherche biomédicale : des déductions beaucoup plus robustes que par le passé sont permises par des études sur de grands nombres de patients, l'accès à de nombreuses informations sur chaque individu permet de mieux connaître les spécificités de chacun, la part d'influence de son génome, de son microbiote, de son environnement (mode de vie) sur sa réponse aux maladies, aux traitements ou aux vaccins (voir encadré ci-dessous). A la clé : une médecine de précision - préventive, personnalisée, prédictive et participative.

1000 volontaires « en bonne santé » pour une médecine de précision

« Quels sont les facteurs génétiques, environnementaux ou liés au mode de vie qui interviennent sur notre réponse immunitaire et font que nous sommes plus ou moins enclins à développer une maladie, à réagir efficacement ou non à tel traitement ou à un vaccin ? C’est à cette question ambitieuse, clé d’une médecine plus personnalisée, que nous cherchons à répondre », explique Lluis Quintana-Murci, responsable à l’Institut Pasteur de l’unité de Génétique évolutive humaine et coordinateur du Consortium Milieu Intérieur, qui réunit 30 équipes de diverses disciplines scientifiques (immunologie, génomique, biologie moléculaire, bioinformatique) de plusieurs institutions de recherche et hôpitaux. « Nous étudions une cohorte* de 1000 volontaires sains de 20 à 70 ans, 500 femmes et 500 hommes. Nous avons déjà recueilli pour chacun une masse considérable de données et en ce moment même, leurs génomes complets sont en train d’être séquencés », précise le chercheur. Des échantillons de sang, de salive, de selles (pour l’étude du microbiote intestinal) ont été collectés pour chaque volontaire et un questionnaire d’environ 200 variables renseigné : âge, poids, taille, antécédents médicaux, habitudes de sommeil, nutrition, tabagisme ou non, données socio-démographiques (revenus, niveau éducatif,..), etc. Pour chaque individu, une partie du sang prélevé a été divisé en une trentaine de tubes, chacun immédiatement stimulé avec un agent pathogène (virus de la grippe, BCG, staphylocoques…) pour mimer une infection et mesurer la réponse immunitaire.

Nous cherchons à savoir quels facteurs génétiques, environnementaux ou liés au mode de vie interviennent sur notre réponse immunitaire et font que nous sommes plus ou moins enclins à développer une maladie.

Lluis Quintana-Murci Responsable de l’unité de Génétique évolutive humaine, à l’Institut Pasteur

« Ces multiples données nous permettent une analyse très poussée combinant – à l’aide d’outils informatiques - les facteurs environnementaux et socio-démographiques avec des facteurs biologiques, notamment le génome, pour savoir avec un haut niveau de précision ce qui participe à la variabilité du système immunitaire », ajoute Lluis Quintana-Murci. « L’espoir avec ces big data est d'appliquer les connaissances issues de cette étude à une médecine de précision, consistant à adapter la bonne stratégie thérapeutique à un patient selon ses caractéristiques personnelles, son profil immunitaire propre, que ce soit vis-à-vis de maladies infectieuses, inflammatoires ou dans le cadre de l’immunothérapie des cancers. » Les premiers résultats ont déjà montré l’impact majeur du tabagisme sur la composition des globules blancs dans le sang, expliquant une plus grande sensibilité aux infections, et permis d’identifier des centaines de variations génétiques modifiant la production de molécules clés de la réponse immunitaire - dont certaines associées à un plus grand risque de développer des maladies comme l’allergie aux pollens, le lupus érythémateux ou le diabète de type 1.

Le Consortium Milieu Intérieur a été labellisé « Laboratoire d’excellence » dans le cadre du programme gouvernemental des Investissements d’Avenir.

*Cohorte gérée par un centre de recherche biomédicale à Rennes.

Le dixième gène du VIH

Olivier Gascuel s’est notamment illustré en 2015 en débusquant grâce à l’analyse génomique de 25 000 souches du virus du sida (VIH)* un gène « caché », dont l’existence était suspectée depuis la fin des années 80, mais très controversée. Il a ainsi confirmé que le génome du virus était bien composé de 10 gènes et non de 9, ouvrant ainsi de nouvelles perspectives thérapeutiques.

Ce chercheur pionnier de la bio-informatique dirige aujourd’hui l’unité de Bioinformatique évolutive et le Centre de bioinformatique, biostatistique et biologie intégrative (C3BI) de l’Institut Pasteur. Le C3BI regroupe une cinquantaine de bio-informaticiens recrutés depuis 2014 pour épauler les équipes du campus en développant des méthodes informatiques et statistiques pour analyser leurs quantités massives de données. « Jusqu’à la fin des années 90, la biologie se faisait devant des tubes à essai ou des boîtes de Petri. Maintenant, elle se pratique aussi bien derrière un ordinateur qu’à la paillasse. » souligne Olivier Gascuel.

L’influence de nos gènes sur l’empathie

« Le Big data a remis en question certaines connaissances », explique Thomas Bourgeron, responsable de l’unité de Génétique humaine et fonctions cognitives à l’Institut Pasteur. « Il était par exemple acquis que les autistes présentaient des anomalies dans une région du cerveau, le corps calleux. Ceci avait été avancé par des études sur de petits nombres de patients. Mais en les reproduisant non pas sur 20 personnes mais sur 500 ou plus, il s’est avéré que cette conclusion était fausse. Aujourd’hui, grâce au Big data, nos analyses sont beaucoup plus robustes. »

Le chercheur a notamment participé à une étude* menée sur 46 000 personnes sur l’empathie, cette faculté d’apporter une réponse émotionnelle adaptée face aux pensées et sentiments d’autrui. Elle suggère que notre empathie n'est pas seulement le résultat de notre éducation et de notre expérience, mais est aussi en partie influencée par nos gènes : un dixième de la variation du degré d’empathie entre les individus serait dû à des facteurs génétiques…

*menée par des chercheurs de l'Université de Cambridge, de l'Institut Pasteur, de l'université Paris Diderot, du CNRS et de la société de génétique 23andMe.

Héritage de l’Homme de Néandertal et immunité

« L’arrivée du Big data nous a ouvert la fenêtre d'une façon spectaculaire », remarque Lluis Quintana-Murci, responsable de l’unité de Génétique évolutive humaine. « Nous pouvons par exemple aujourd’hui étudier le système immunitaire inné, notre première ligne de défense contre les pathogènes, dans son ensemble. Alors qu’il y a peu nous analysions deux ou trois gènes impliqués dans cette immunité, nous en étudions désormais plus de 1500. » Son équipe a récemment montré que les gènes impliqués dans notre système immunitaire inné sont enrichis en héritage de l’Homme de Néandertal. Cette connaissance de l’histoire évolutive humaine - tout comme la comparaison des génomes actuels de différentes populations (Européens, Africains, Asiatiques…) - permet de repérer les gènes les plus importants, ceux qui nous ont permis de nous adapter au mieux et de survivre aux pathogènes. « Le Big data a révolutionné nos recherches sur la biodiversité des génomes. Or étudier la variabilité génétique des populations est primordial pour comprendre nos inégalités face à la maladie, mais aussi face à la réponse aux traitements ou aux vaccins. »

Unis pour comprendre l’émergence des maladies. Ces trois chercheurs et plusieurs autres équipes de l’Institut Pasteur participent au vaste projet Inception, lancé en 2016 dans le cadre du programme gouvernemental « Investissements d’avenir » : à la croisée de la biologie « intégrative », des sciences sociales et de l’analyse des données, il a pour but d’étudier l’émergence des maladies - infectieuses (Ebola, Zika, sida...) et autres (cancers, autisme…) - chez les individus et dans les populations.